陈丹琦团队又带着他们的降本大法来了——澳门六合彩

数据砍掉三分之一,大模子性能却完全不减。

直播吧01月07日讯 意大利超级杯决赛,国米对阵米兰。93分钟,亚伯拉罕破门,米兰连扳三球3-2国米。

他们引入了元数据,加速了大模子预试验的同期,也不增多单独的计较支拨。

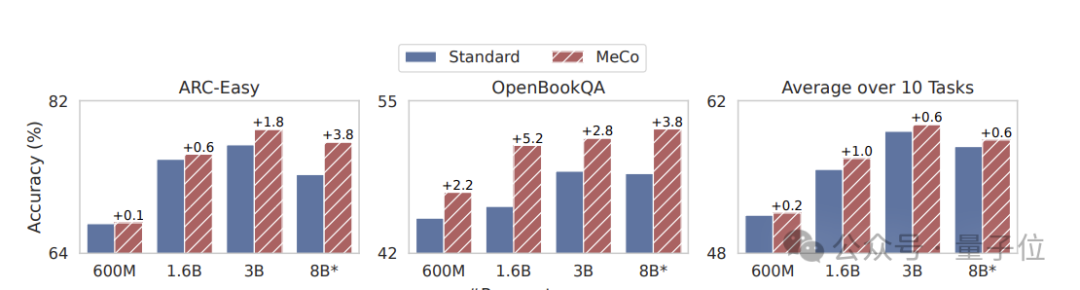

在不同模子范畴(600M - 8B)和试验数据来源的情况下,均能终局性能方面的普及。

固然之前元数据道过许多,但一作高天宇默示,他们是第一个展示它奈何影响下贱性能,以及具体奈何推行以确保推理中具备大宗实用性。

来望望具体是奈何作念到的吧?

元数据加速大模子预试验

说话模子预试验语料库中存在着立场、规模和质地水平的强大各异,这关于开辟通用模子智商至关遑急,关联词高效地学习和部署这些异构数据源中每一种数据源的正确活动却极具挑战性。

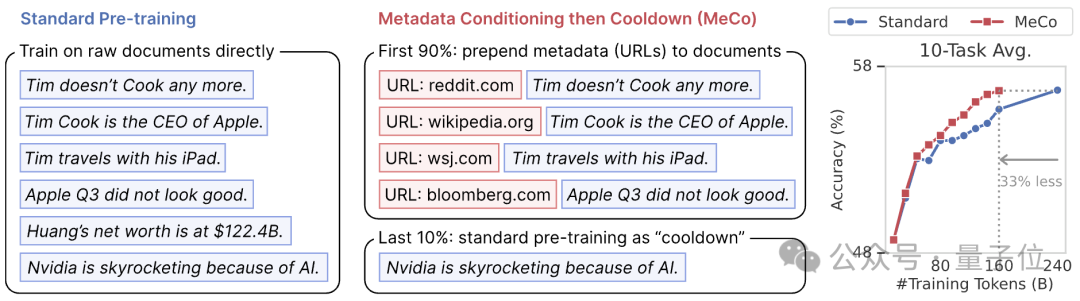

在这一配景下,他们提议了一种新的预试验阵势,称为元数据退换然后冷却(MeCo,Metadata Conditioning then Cooldown)。

具体包括两个试验阶段。

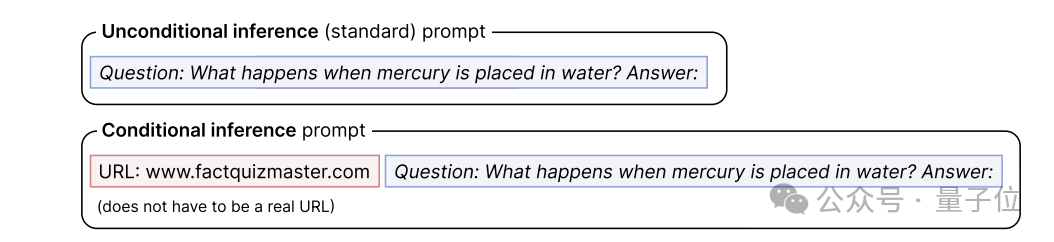

预试验阶段(90%)澳门六合彩,将元数据(如文档 URL 的扫数域名c)与文档拼接(如 “URL: en.wikipedia.org [document]”)进行试验。

(举例,如若文档的 URL 是 https://en.wikipedia.org/wiki/Bill Gates,那么文档 URL 的扫数域名c即是 en.wikipedia.org;这种 URL 信息在许多预试验语料库中齐很容易得回,它们大多来自 CommonCrawl2(一个怒放的麇集捏取数据存储库))

当使用其他类型的元数据时,URL 应替换为相应的元数据称呼。

他们只计较文档记号的交叉熵蚀本,而不谈判模板或元数据中的记号,因为在初步实验中发现,对这些记号进行试验会稍许挫伤下贱性能。

终末10%的试验阵势为冷却阶段,使用程序数据试验,接受元数据退换阶段的学习率和优化器现象,即从上一阶段的终末一个查验点驱动化学习率、模子参数和优化器现象,并持续把柄筹画救援学习率:

1)禁用跨文档Attention,这既加速了试验速率(1.6B 模子的试验速率提高了 25%),又提高了下贱性能。

2)当将多个文档打包成一个序列时,咱们确保每个序列从一个新文档来源,而不是从一个文档的中间来源—当将文档打包成固定长度时,这可能会导致一些数据被丢弃,但事实融会这故意于提凹凸游性能。

本次实验使用了Llama Transformer架构和Llama-3 tokenizer。咱们使用四种不同的模子大小进行了实验:600M、1.6B、3B 和 8B,以及关系优化成就。

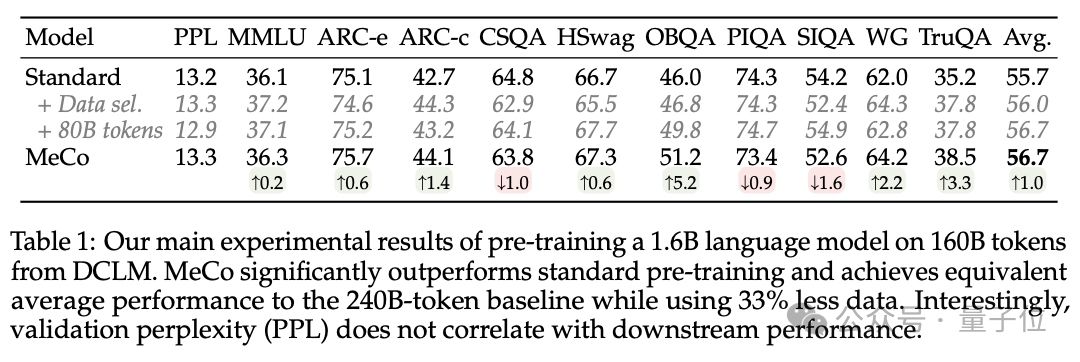

抑止披露,MeCo 的发扬光显优于程序预试验,其平均性能与 240B 记号的基线很是,而使用的数据却减少了 33%。

终末回想,他们主要完成了这三项孝敬。

1、 MeCo 大幅加速了预试验。

实考融会,MeCo 使一个 1.6B 的模子在少用 33% 的试验数据的情况下,达到了与程序预试验模子相似的平均下贱性能。在不同的模子范畴(600M、1.6B、3B 和 8B)和数据源(C4、RefinedWeb 和 DCLM)下,MeCo 披败露一致的收益。

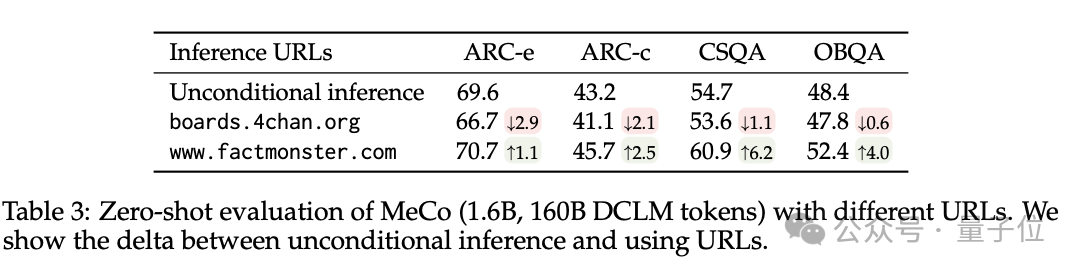

2、MeCo 开启了指挥说话模子的新阵势。

举例,使用factquizmaster.com(非委果URL)不错提高知识性任务的性能(举例,在零次知识性问题解答中扫数提高了6%),而使用wikipedia.org与程序的无条款推理比较,毒性生成的可能性镌汰了数倍。

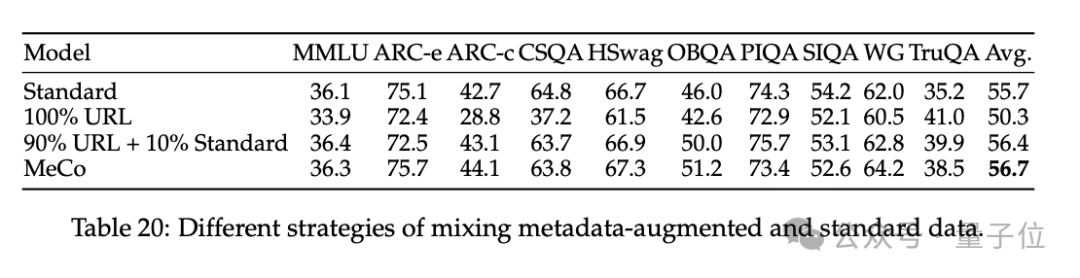

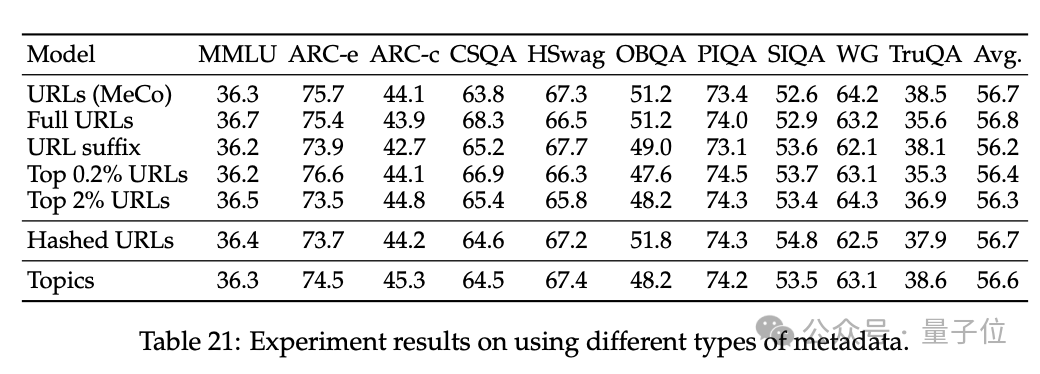

3、消解了 MeCo 的野心采取,并融会 MeCo 与不同类型的元数据兼容。

使用散列 URL 和模子生成的主题进行的分析标明,元数据的主要作用是按来源将文档归类。因此,即使莫得URL,MeCo 也能灵验地整合不同类型的元数据,包括更风雅的选项。

陈丹琦团队

论文作家来自普林斯顿NLP小组(附庸于普林斯顿说话与智能PLI)博士生高天宇、Alexander Wettig、Luxi He、YiHe Dong、Sadhika Malladi以及陈丹琦。

一作高天宇,本科毕业于清华,是2019年清华特奖得主,当今普林斯顿五年齿博士生,预测本年毕业,持续在学界搞盘问,盘问规模包括当然说话贬责和机器学习的交叉规模,极度柔软大说话模子(LLM),包括构建愚弄门径、提高LLM功能和成果。

Luxi He当今是普林斯顿计较机专科二年齿博士生,当今盘问要点是清醒说话模子并改善其一致性和安全性,硕士毕业于哈佛大学。

YiHe Dong当今在谷歌从事机器学习盘问和工程职责,专注于结构化数据的默示学习、自动化特征工程和多模态默示学习,本科毕业于普林斯顿。

— 完 —澳门六合彩